Theo cựu nhân viên này, ‘Việc bảo toàn thế giới tự do khỏi các quốc gia độc tài đang gặp rủi ro.’

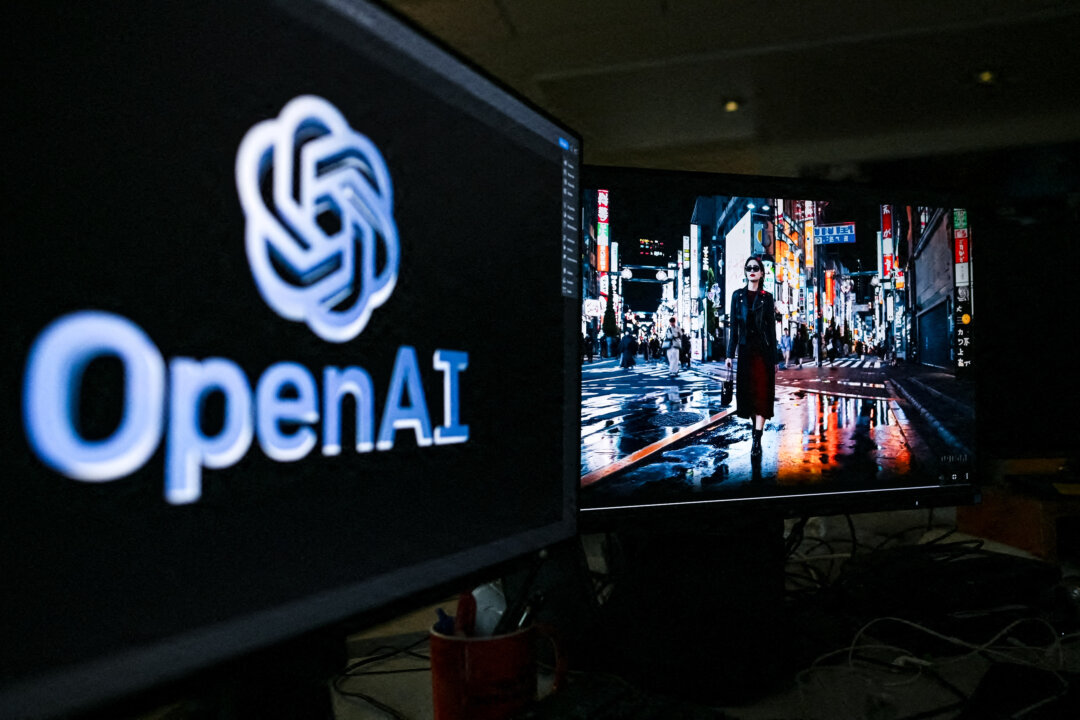

Ảnh chụp một cảnh trong video do một công cụ trí tuệ nhân tạo mới tên là “Sora” tạo ra, do công ty OpenAI công bố, tại Paris vào ngày 16/02/2024. (Ảnh: Stefano Rellandini/AFP qua Getty Images)

Nathan Worcester

Thứ hai, 24/6/2024

Một nhà nghiên cứu bị OpenAI sa thải đã dự đoán rằng trí tuệ nhân tạo tổng quát (AGI) sở hữu trí thông minh giống như con người là điều có thể đạt được vào năm 2027, đồng thời gióng lên hồi chuông cảnh báo về mối đe dọa gián điệp của Trung Quốc trong lĩnh vực này.

“Một khi Đảng Cộng sản Trung Quốc (ĐCSTQ) biết được về AGI, thì chúng ta nên lường trước là sẽ có những nỗ lực to lớn từ phía ĐCSTQ để cạnh tranh. Và tôi nghĩ có một con đường khá rõ ràng để Trung Quốc tham gia cuộc chơi: xây dựng nền tảng nhanh hơn Hoa Kỳ và đánh cắp các thuật toán,” nhà nghiên cứu trẻ tuổi tên Leopold Aschenbrenner này viết.

Anh Aschenbrenner lập luận rằng nếu không có các biện pháp an ninh nghiêm ngặt, thì ĐCSTQ sẽ khai thác được “những đột phá quan trọng về AGI” trong vài năm tới.

“Đây sẽ là điều hối tiếc lớn nhất của cơ quan an ninh quốc gia trước khi thập niên này kết thúc,” anh viết, đồng thời cảnh báo rằng “việc bảo toàn thế giới tự do khỏi các quốc gia độc tài đang gặp rủi ro.”

Anh cho rằng cần tăng cường năng lực bảo mật cho các trọng số của mô hình AI — các giá trị số phản ánh sức mạnh kết nối giữa các neuron nhân tạo — và đặc biệt là các bí quyết thuật toán, một lĩnh vực mà anh nhận thấy hiện đang có những thiếu sót nghiêm trọng.

“Tôi nghĩ thất bại trong việc bảo vệ các bí quyết thuật toán có lẽ là cách thức khả thi nhất để Trung Quốc có thể duy trì tính cạnh tranh trong cuộc đua AGI,” anh viết. “Quả thật không phải là phóng đại khi nói rằng mức độ bảo mật đối với các bí quyết thuật toán hiện nay là rất tệ hại.”

Anh Aschenbrenner cũng lập luận rằng AGI có thể tạo tiền đề cho siêu trí tuệ nhân tạo (artificial superintelligence) trong hơn nửa thập niên tới thông qua tự động hóa hoạt động nghiên cứu AI.

Với tựa đề “Nhận thức về Tình huống: Thập niên Phía trước” (Situational Awareness: The Decade Ahead), loạt bài của anh Aschenbrenner đã kích khởi một loạt phản ứng trong thế giới công nghệ. Nhà khoa học máy điện toán Scott Aaronson đã mô tả đây là “một trong những tài liệu đặc biệt nhất mà tôi từng đọc,” trong khi kỹ sư phần mềm Grady Booch viết trên X rằng nhiều yếu tố trong đó “sai lầm một cách sâu sắc, đáng xấu hổ, và đáng kinh ngạc.”

Trong một bài báo, tác giả Jason Lowe-Green thuộc Trung tâm Chính sách AI (CAIP) đã tán dương bài viết của anh Aschenbrenner, đồng thời nhận định; “Đã đến lúc chúng ta ban hành các quy định quản lý lĩnh vực này.”

Bàn về sự đề cập của anh Aschenbrenner đến cuộc chạy đua AI giữa Hoa Kỳ và Trung Quốc trong bài đăng trên X, ông Jason Colbourn thuộc Chiến dịch vì An toàn AI (Campaign for AI Safety) đã đề nghị tiến hành một “hiệp ước không phổ biến vũ khí AI toàn cầu, bắt đầu bằng hiệp ước song phương giữa Hoa Kỳ và ĐCSTQ.”

Đồng thời, trong những tuần gần đây, các nhà nghiên cứu AI của Google và DeepMind đã phát hành một bức thư cảnh báo rằng công nghệ AI gây ra “những rủi ro nghiêm trọng”, lớn đến mức bao gồm cả nguy cơ gây “tuyệt chủng cho nhân loại.”

Quy định về AI

Loạt bài “Nhận thức về Tình huống” của anh Aschenbrenner được công bố trong bối cảnh các nhà lập pháp ở Hoa Kỳ và trên toàn thế giới đang cân nhắc các quy định về AI.

Hồi tháng 03/2023, Nghị viện Âu Châu đã thông qua một dự luật có ảnh hưởng sâu rộng, mang tên Đạo luật Trí tuệ Nhân tạo, vài tháng sau khi các quốc gia thành viên đạt được thỏa thuận về luật này.

Đạo luật ENFORCE lưỡng đảng, được giới thiệu gần đây tại Quốc hội Hoa Kỳ, sẽ cho phép Cục Công nghiệp và An ninh của Bộ Thương mại áp dụng các biện pháp kiểm soát xuất cảng đối với công nghệ AI.

Trong một tuyên bố đưa ra hôm 10/05 về dự luật này, thành viên cấp cao trong Ủy ban Đặc biệt về ĐCSTQ của Hạ viện Hoa Kỳ, Dân biểu Raja Krishnamoorthi (Dân Chủ-Illinois), đã cảnh báo rằng “theo luật hiện hành, cộng đồng an ninh quốc gia của chúng ta không có thẩm quyền cần thiết” để ngăn chặn ĐCSTQ, quân đội của họ, cũng như các công ty mà họ trực tiếp kiểm soát mua lại các hệ thống AI có khả năng trợ giúp các cuộc tấn công mạng chống lại Hoa Kỳ trong tương lai.”

Anh Aschenbrenner cho biết bộ phận nhân sự của OpenAI gọi những lời cảnh báo của anh về ĐCSTQ là ‘phân biệt chủng tộc’

Anh Aschenbrenner đã phát hành loạt bài “Nhận thức về Tình huống” vài tháng sau cuộc chia ly gây tranh cãi của mình với OpenAI, nơi anh làm việc trong nhóm Superalignment. (Nhiệm vụ của nhóm này là bảo đảm rằng các hệ thống AI tân tiến, đặc biệt là AGI, hoạt động theo cách phù hợp với các giá trị và lợi ích của con người).

The Information đưa tin hồi tháng 04/2024 rằng anh Aschenbrenner và một nhân viên khác của OpenAI đã bị sa thải sau các “cáo buộc làm rò rỉ thông tin.”

Trong cuộc phỏng vấn hôm 04/06 với podcaster Dwarkesh Patel, anh Aschenbrenner đã trả lời một câu hỏi về bài báo đó. Anh cho biết “thông tin bị rò rỉ” được cho là về khung thời gian áp dụng AGI trong một tài liệu bảo mật mà anh đã chia sẻ với ba nhà nghiên cứu không liên kết với OpenAI.

Anh nói: “Về bối cảnh, vào thời điểm đó việc chia sẻ các ý tưởng về an toàn với các nhà nghiên cứu bên ngoài OpenAI để nhận phản hồi là điều hoàn toàn bình thường.”

Tuy nhiên, anh Aschenbrenner cho rằng việc anh bị sa thải có liên quan đến những lo ngại mà anh đã nêu về hành vi đánh cắp tài sản trí tuệ của Trung Quốc.

Anh nói với ông Patel rằng anh đã chính thức bị bộ phận nhân sự của OpenAI khiển trách sau khi soạn thảo một bản ghi nhớ bảo mật đề cập đến mối đe dọa của ĐCSTQ và chia sẻ tài liệu này với hội đồng quản trị của OpenAI.

“Nhân viên nhân sự nói với tôi rằng việc lo lắng về hoạt động gián điệp của ĐCSTQ là hành vi phân biệt chủng tộc,” anh kể lại. Anh cho biết thêm rằng sau đó anh đã được thông báo rằng mình đã bị sa thải chứ không đơn thuần là chỉ bị cảnh cáo vì bản ghi nhớ đó.

The Epoch Times đã liên lạc với OpenAI để yêu cầu bình luận về những cáo buộc của anh Aschenbrenner.

Hai đồng trưởng nhóm của nhóm Superalignment là Ilya Sutskever và Jan Leike, đều đã rời OpenAI vào giữa tháng 05/2024.

Trưởng nhóm Leike viết trên X: “Trong những năm qua, văn hóa và quy trình an toàn đã nhường chỗ cho các sản phẩm bóng bẩy.”

“Thời điểm đã là quá muộn để chúng ta trở nên vô cùng nghiêm túc về tác động của AGI. Chúng ta phải ưu tiên chuẩn bị cho những tác động này tốt nhất có thể,” anh nói thêm.

Trong loạt bài “Nhận thức về Tình huống” của mình, anh Aschenbrenner, một nhà nghiên cứu gốc Đức tốt nghiệp thủ khoa Đại học Columbia ở tuổi 19, cũng đã gửi lời cảm ơn đến trưởng nhóm Sutskever, một nhà khoa học máy điện toán người Canada gốc Israel và Nga.

Minh Đức biên dịch

Quý vị tham khảo bản gốc từ The Epoch Times